Autor: Nebu Philips, Director de Desarrollo de Estrategia y Negocio, Synaptics Incorporated

La necesidad y las oportunidades de Edge AI (inteligencia artificial distribuida) en IoT (internet de las Cosas) son claras y notables, pero hay retos por delante y las soluciones se han mostrado lentas a la hora de aprovechar esa necesidad y esas oportunidades. Un panorama formado por soluciones complejas y heterogéneas, el aprovechamiento de dispositivos de silicio y motores de IA ya existentes en lugar de recurrir a soluciones especializadas, la falta de directrices y normas, junto a la ausencia de herramientas y entornos de desarrollo, han venido caracterizando la situación hasta ahora.

Pero ahora empresas como Synaptics están aplicando un método con “IA nativa” y ofreciendo plataformas informáticas con SoC (systems on chips) especializados, software de código abierto y herramientas que ayudar a vencer los obstáculos de adopción y acelerar la integración de funciones de IA en dispositivos Edge IoT. Veamos cuáles son las oportunidades, los retos y las soluciones.

Auge de Edge AI en la informática embebida

El mundo de la alta tecnología, en el que la IA generativa (GenAI) protagoniza los titulares, está viviendo un movimiento transformador en el edge (borde o periferia). El concepto Edge AI está demostrando ser primordial en los sistemas informáticos embebidos, donde se necesita un análisis rápido de datos multimodo como vídeo, visión, voz y audio para varias transmisiones.

Los algoritmos de aprendizaje automático (ML, por Machine learning), con su mayor capacidad de reconocimiento de patrones, se están convirtiendo en la solución de referencia para estas tareas, superando así a la codificación basada en reglas tradicionales, sobre todo a gran escala. Los desarrolladores optan cada vez más por implementar algoritmos de inferencia IA en procesadores compactos y embebidos para obtener información procesable de inmediato directamente en la fuente de datos. Este enfoque acaba con las preocupaciones por los costes, la complejidad, los retardos, la privacidad y la seguridad que caracterizan a la transmisión de datos sin procesar a servicios en la nube, pero carga con problemas que van desde el estado actual de la tecnología y la complejidad inherente del ecosistema IoT.

Desafíos de la integración de IA en IoT

El panorama del edge computing o computación distribuida está muy fragmentado, ya que existe una enorme cantidad de soluciones deficientes e incompatibles de hardware y software. Al mismo tiempo, el desarrollo de software para IA y ML avanza a un ritmo frenético, generando así un rico ecosistema que carece de una clara dirección.

Para complicar aún más las cosas, estos avances en el software no siempre se ven correspondidos por un desarrollo equivalente del hardware, que suele evolucionar a mayor lentitud debido a las importantes inversiones y el tiempo que exigen el desarrollo físico y la producción. Como consecuencia de ello, a menudo se produce una desconexión entre the prestaciones del software más avanzado y el rendimiento del hardware existente, lo cual provoca ineficiencia y lentitud al implementar la IA de manera distribuida.

Los fabricantes recurren con frecuencia a chips de silicio readaptados porque fueron diseñados para otros mercados, como smartphones o electrónica de consumo, para utilizarlos en aplicaciones IoT. Esta práctica puede ocasionar varios problemas. Los chips que no están optimizados para las necesidades propias de IoT edge, como bajo consumo y procesamiento en tiempo real, pueden dar como resultado unos dispositivos ineficientes o que no proporcionan el rendimiento necesario. En cambio pueden alcanzar un mayor rendimiento informático del requerido por una aplicación IoT, con el consiguiente desperdicio de recursos.

El ecosistema IoT es diverso pues está constituido por una multitud de dispositivos, cada uno de los cuales tiene sus propios requisitos. La ausencia de plataformas y protocolos comunes complica aún más la integración de la IA en dispositivos IoT. Sin unas normas aceptadas de forma universal, los dispositivos de diferentes fabricantes pueden tener dificultades para comunicarse entre sí o con sistemas centrales, con los problemas de interoperabilidad correspondientes.

Todo ello puede afectar a la innovación, incrementar los costes de desarrollo y ralentizar la adopción de soluciones edge computing inteligentes. Superar estos obstáculos exige la colaboración del sector para desarrollar plataformas de hardware armonizadas, establecer unas normas comunes y fomentar un ecosistema que apoye la total integración de IA en dispositivos Edge IoT.

Principales componentes de las plataformas IA embebidas

Para garantizar el éxito de las plataformas Edge AI se necesitan plataformas avanzadas que hayan sido especialmente diseñadas para informática embebida. Estas plataformas deben lograr un delicado equilibrio entre diversos factores, como rendimiento, eficiencia, formato, conectividad, configuraciones de E/S y rentabilidad.

Los SoC para Edge AI han de ser acelerados, es decir, dotados de una mayor capacidad de procesamiento para manejar cargas de trabajo de IA de manera eficiente. Esta aceleración se logra a menudo por medio de funciones de procesamiento especializadas como unidades NPU (neural processing units) o GPU (graphics processing units) que pueden realizar con rapidez los cálculos complejos que exigen los algoritmos de IA.

Los kits de software de plataformas integrales son vitales y deben incluir todas las herramientas, bibliotecas y recursos que necesitan los desarrolladores para crear, comprobar e implementar aplicaciones de IA. Un kit de software bien diseñado simplifica el proceso de desarrollo para que los desarrolladores se puedan centrar más en la innovación que en los entresijos de la plataforma subyacente.

Los dispositivos IoT también necesitan a menudo comunicarse entre sí y con servicios basados en la nube, de ahí que sea primordial contar con una comunicación inalámbrica fiable y segura. El complimiento de las normas garantiza que lo dispositivos puedan funcionar perfectamente y que la plataforma admita numerosos protocolos de conectividad, desde Wi-Fi y Bluetooth hasta redes IoT más especializadas como Zigbee y Thread/Matter.

Los entornos de modelos proporcionan la estructura y las herramientas para desarrollar y ejecutar modelos de IA. Deben ser compatibles con un conjunto de algoritmos de IA y ML, así como capaces optimizar estos modelos para su ejecución eficiente en el hardware de la plataforma. Un potente entorno de IA también incluye herramientas para entrenar modelos de IA, implementarlos y gestionarlos en dispositivos edge.

Finalmente, para el crecimiento y la sostenibilidad de plataformas Edge AI, es imprescindible contar con un dinámico ecosistema de socios. Este ecosistema está constituido por proveedores de hardware, desarrolladores de software, proveedores de servicios y usuarios finales que colaboran para impulsar la innovación y garantizar que la plataforma cubre las diferentes necesidades del mercado. Un potente ecosistema también acelerará el desarrollo y proporcionará unas valiosas sugerencias que servirán para introducir mejoras y ayudarán a crear un amplio conjunto de aplicaciones y servicios que se puedan ejecutar en la plataforma.

La plataforma AstraTM Synaptics es un ejemplo de materialización de estos componentes fundamentales que ofrece una solución completa para procesamiento de IA destinado a IoT. Gracias a la integración de hardware SoC escalable, software de código abierto y un kit de herramientas de IA, conectividad basada en normas, un potente entorno de IA y un ecosistema formado por socios colaborativos, la plataforma Astra está bien preparada para cubrir los requisitos de las modernas aplicaciones Edge AI. Veamos cuáles son sus principales características.

Plataforma Astra de “IA nativa” para Edge IoT

El catálogo de dispositivos Astra de Synaptics costa desde un inicio de tres SoC (la Serie SL), todos ellos basados en procesadores Arm® Cortex®-A y equipados con GPU y un conjunto completo de E/S. Estos SoC están diseñados a partir de un profundo conocimiento de los requisitos de las aplicaciones de IA para plataformas edge, desde aplicaciones básicas hasta alto rendimiento. Los SoC de la Serie SL también incorporan seguridad acelerada por hardware, vídeo, gráficos y audio para cargas de trabajo IoT multimodo en entornos de consumo, empresariales e industriales con un rendimiento de hasta 8 TOPS.

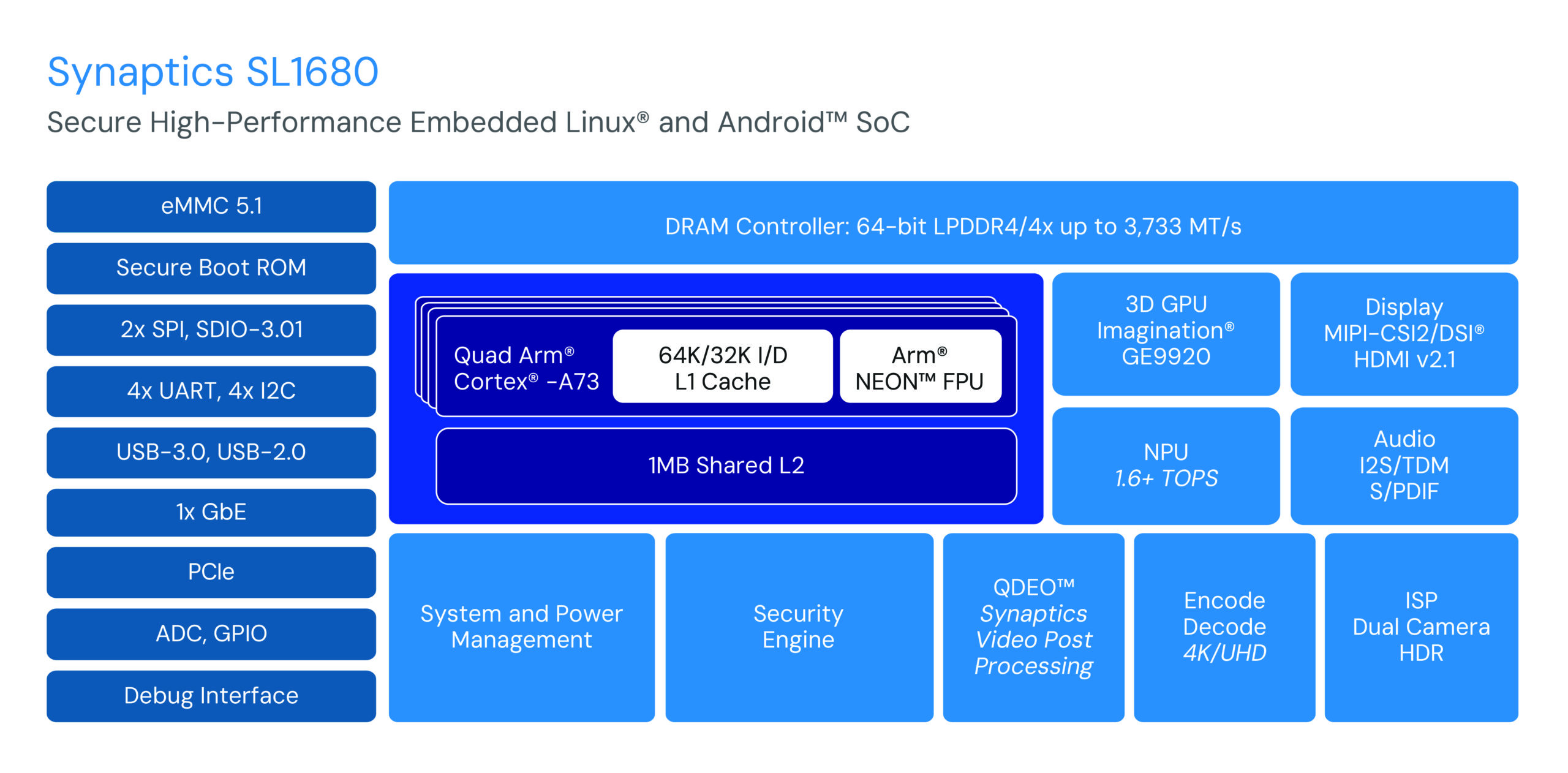

Diagrama de bloques del SL1680, un SoC basado en Arm® Cortex®-A para aplicaciones AI Edge IoT.

La reciente ampliación de la plataforma Astra incluye la Serie SR de SoC con microcontroladores de inferencia escalonada que ofrecen un procesamiento en función del contexto en varios entornos. Estos chips con IA nativa y consumo optimizado aprovechan los mismos entornos de IA que la Serie SL para que las aplicaciones sean rentables y puedan ser alimentadas por baterías.

Para los desarrolladores, el kit de evaluación Astra Machina Foundation Series ofrece un entorno de diseño modular con una placa madre de E/S que admite módulos con núcleo intercambiable para cada chip de las series SL y SR. La flexibilidad y la escalabilidad se ven aumentadas aún más con tarjetas hijas para conectividad inalámbrica que utilizan las soluciones Veros de Synaptics y la expansión del número de E/S, agilizando de este modo el proceso de prototipado.

El kit de evaluación Astra Machina Foundation Series proporciona un entorno de diseño modular con una placa madre de E/S que admite módulos de núcleo intercambiable para cada chip de las series SL y SR.

Synaptics acumula una larga experiencia en la aplicación de técnicas de IA en aplicaciones multimodo. El paquete de herramientas SyNAP, desarrollado para ser compatible con Edge AI en chips multimedia de alto rendimiento, es ahora la piedra angular del entorno del modelo estandarizado Astra de IA nativa. Por ejemplo, se pueden descargar modelos YOLO para detección de caras en formatos TensorFlow Lite y ONNX, ejecutarlos como tales en el kit de evaluación Astra Machina y utilizar SyNAP para mejorar la latencia hasta en dos órdenes de magnitud.

La biblioteca Astra GitHub alberga un conjunto completo de software de código abierto para la plataforma que incluye Yocto Linux, el kit Astra, el paquete de herramientas SyNAP y una amplia documentación. Este enfoque unificado del software simplifica el proceso de desarrollo por lo que permite a los desarrolladores iniciar con rapidez la implementación de aplicaciones con la plataforma Astra.

El futuro de Edge AI para IoT con Astra

La plataforma Astra marca un importante hito en la evolución de Edge AI en su transición de una función experimental a un componente indispensable de la arquitectura de la plataforma embebida. Gracias a su plataforma madura y probada de IA, las numerosas opciones de conectividad y el potente ecosistema de empresas asociadas, Synaptics está bien posicionada para cubrir la creciente demanda de dispositivos embebidos inteligentes. El panorama de IoT no deja de evolucionar y la plataforma Astra está llamada a desempeñar un papel primordial para permitir el uso de IA multimodo.